该模型是一个尺寸合理的中文模型,能够在零样本以及少样本的情境下完成包多语言任务在内的多种 NLP 任务。

体验链接:https://welm.weixin.qq.com/docs/playground/

API 接口:https://welm.weixin.qq.com/docs/api/

论文地址:https://arxiv.org/abs/2209.10372

其他相关参考链接:

微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩——量子位

https://baijiahao.baidu.com/s?id=1746546375886224043&wfr=spider&for=pc

大规模语言模型领域迎来新“选手”。近日,微信 AI 推出自研 NLP 大规模语言模型 WeLM ,该模型是一个尺寸合理的中文模型,能够在零样本以及少样本的情境下完成包多语言任务在内的多种 NLP 任务。

同时,微信 AI 团队也提供了 WeLM 的体验网页和 API 接口,感兴趣的用户可前往https://welm.weixin.qq.com/docs/体验和申请 API 接口,相关技术论文《WeLM: A Well-Read Pre-trained Language Model for Chinese》也已经发布于论文预印本网站 arXiv。

NLP 大模型迎新选手,WeLM 提供交互式网页 PlayGround 和 API 接口

在近几年自然语言处理(NLP)领域的发展浪潮中,OpenAI 开发的自然语言处理模型 GPT-3 无疑风头无两,发布之初便以 1750 亿参数规模的预训练模型所表现出来的零样本与小样本学习能力刷新了人们的认知,也引爆了 AI 大模型研究的热潮。

对业界来说,预训练大模型降低了 AI 应用的门槛,距离“AI 把人类从重复性劳动中解放出来”的宏伟目标越来越近,目前,基于 GPT-3,全球开发者已经探索出包括编程、回复邮件、UI 设计、回答数学问题、法律语言转化、总结中心思想、推理、文本处理等广泛应用场景,并且,各国研究者在多语言/多任务等角度的探索也正在谱写大模型百家争鸣的新篇章。

而在国内以中文为核心的大规模语言模型领域,微信 AI 推出的百亿级别大规模语言模型 WeLM,便是大模型百家争鸣中的新选手。

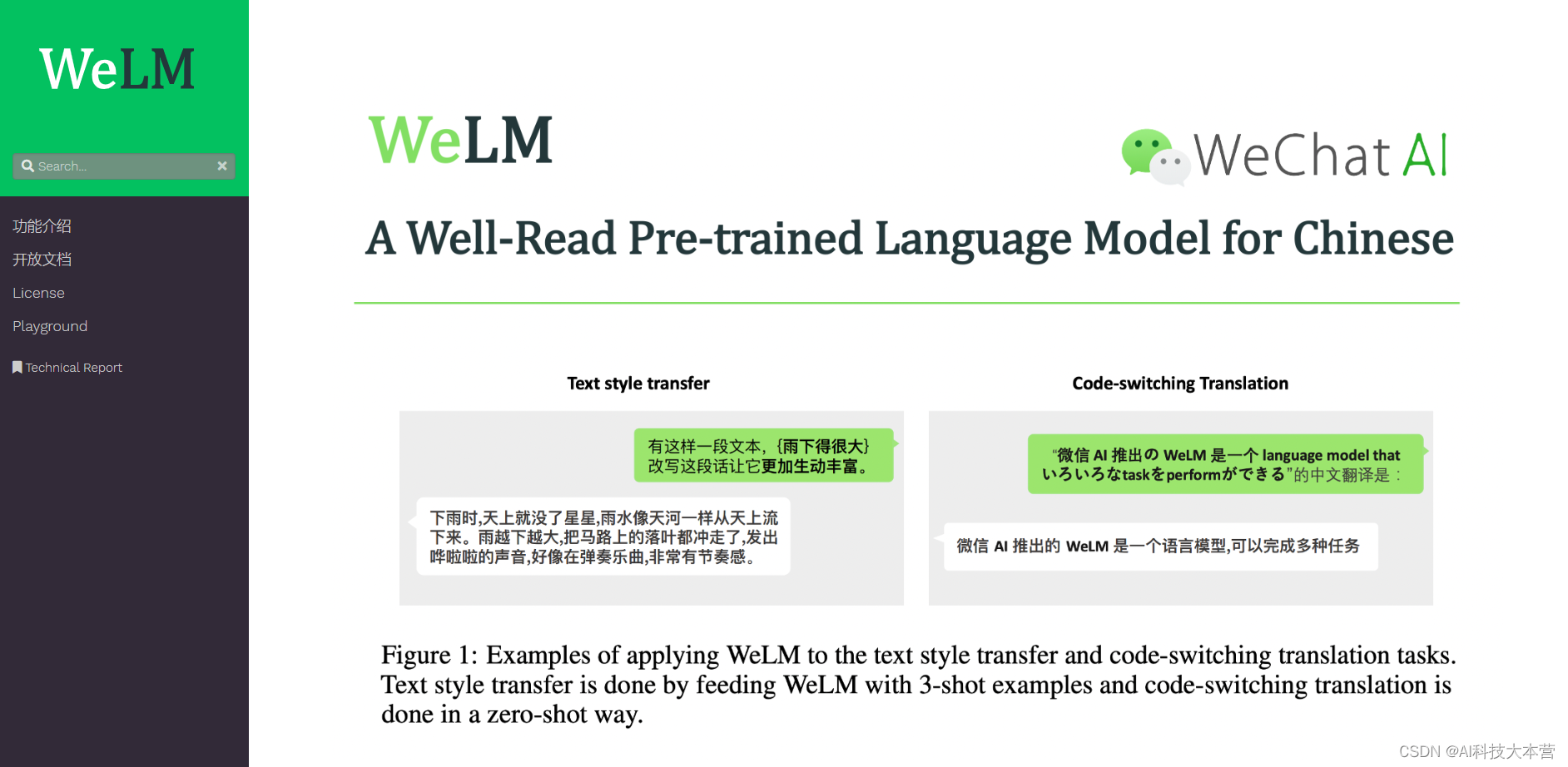

据介绍,WeLM 是一个百亿级别的中文模型,能够在零样本以及少样本的情境下完成包括对话-采访、阅读理解、翻译、改写、续写、多语言阅读理解在内的多种 NLP 任务,并具备记忆能力、自我纠正和检查能力。并且,WeLM 具有尺寸合理的优势,在 14 项中文 NLP 任务上,WeLM 的整体表现超出了所有同大小的模型,甚至能够匹配比它大 25 倍的模型。

以被普遍认为是更困难的 NLP 任务的文本风格转换(改写)为例,尽管用户给出的 5 个例子和最后需要生成的例子并没有重合的风格转换类型,但 WeLM 拥有出色的举一反三能力,通过学习少量的文本转换例子即可达到对任意类型的文本转换。并且,WeLM 在对话-采访、阅读理解、翻译、续写等多个中文文本生成任务中有着同样优异的表现。